Un algoritmo de inversión recomienda una acción que se desploma, causando pérdidas millonarias. Un sistema de diagnóstico médico falla al identificar un tumor maligno en una radiografía. A medida que la inteligencia artificial se integra en sectores críticos, emerge una pregunta legal urgente y compleja: si la IA se equivoca, ¿quién paga los platos rotos?

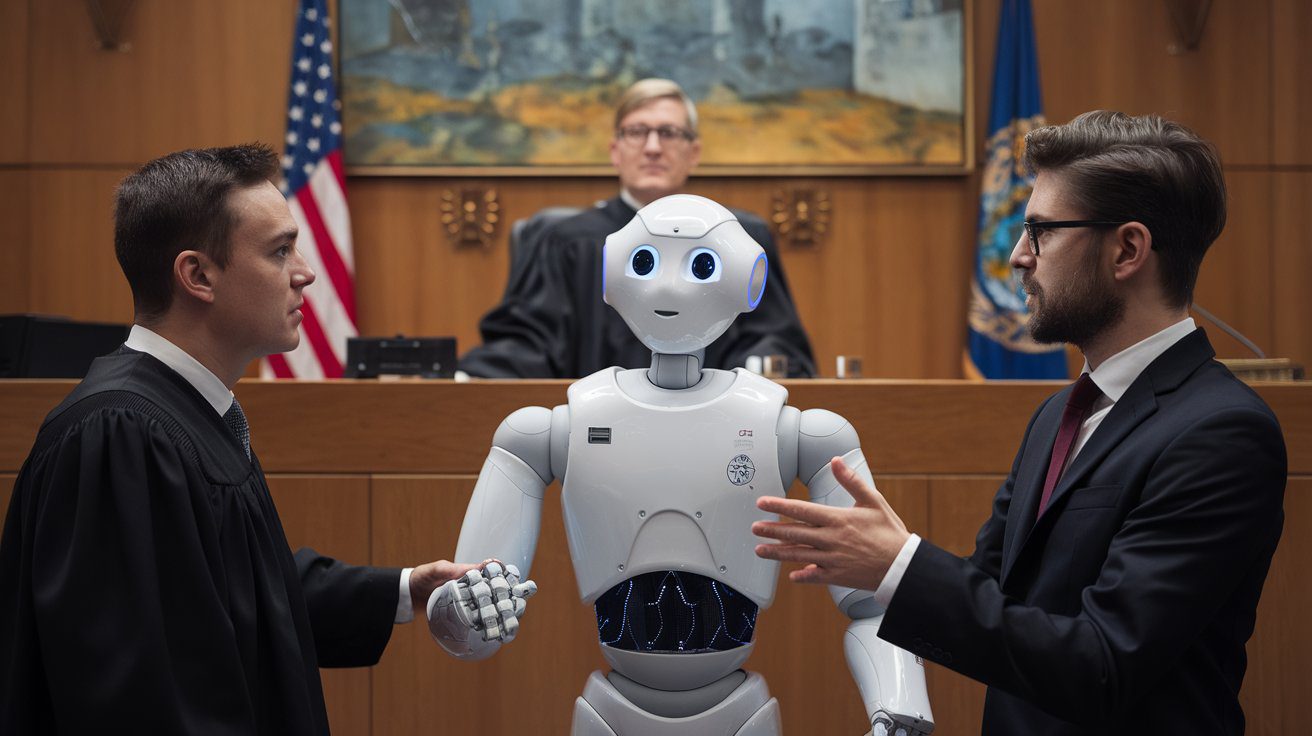

La era de la inteligencia artificial promete revolucionar industrias como la financiera y la médica, ofreciendo análisis de datos a una velocidad y escala sobrehumanas. Sin embargo, esta promesa viene acompañada de un vacío legal que genera una profunda incertidumbre. Cuando un consejo automatizado resulta ser perjudicial, el tradicional concepto de culpabilidad se diluye. Ya no hay un profesional humano directamente responsable, sino una red de programadores, empresas y usuarios. Este artículo explora el laberinto de la responsabilidad algorítmica y los posibles culpables en el banquillo.

El Dilema de la “Caja Negra”: Desentrañando la Cadena de Responsabilidad

El principal desafío legal de la IA es su naturaleza de “caja negra”. A menudo, ni siquiera sus propios creadores pueden explicar completamente cómo un algoritmo de aprendizaje profundo llega a una conclusión específica. Esto complica enormemente la tarea de asignar culpas. Sin embargo, los expertos legales barajan varias figuras como posibles responsables.

1. El Desarrollador y el Fabricante: ¿La Culpa es de Quien lo Creó?

La primera mirada apunta hacia los programadores y la empresa que desarrolló el software. Se podría argumentar que son responsables por negligencia en el diseño, por utilizar datos de entrenamiento sesgados o insuficientes, o por no haber previsto y mitigado los riesgos de errores. Por ejemplo, si una IA financiera fue entrenada con datos de mercado de una década alcista, podría no estar preparada para una recesión, llevando a consejos desastrosos. La pregunta clave será: ¿el desarrollador tomó las precauciones razonables y siguió los estándares de la industria?

2. La Empresa u Operador: ¿Responsabilidad por el Uso de la Herramienta?

Otra línea de responsabilidad apunta a la entidad que implementa la IA y la ofrece a sus clientes, ya sea un banco, una firma de corretaje o un hospital. Esta entidad tiene el deber de diligencia de seleccionar herramientas de IA fiables, validarlas rigurosamente y supervisar su rendimiento. Si un hospital utiliza un software de diagnóstico conocido por tener una tasa de error significativa en ciertos tipos de pacientes sin implementar una segunda revisión humana, podría ser considerado legalmente culpable por los daños causados por un diagnóstico erróneo.

3. El Usuario Profesional: ¿El Experto Sigue Siendo el Responsable Final?

En muchos escenarios, la IA es una herramienta de apoyo para un profesional humano, como un médico o un asesor financiero. En estos casos, la doctrina legal podría sostener que la responsabilidad final recae en el humano que acepta y transmite el consejo de la IA. El argumento es que el profesional debe usar su propio juicio y experiencia para evaluar la recomendación del algoritmo antes de presentarla al cliente. La dependencia ciega en la tecnología, sin un análisis crítico, podría ser considerada una negligencia profesional.

El Futuro Legal: Hacia una “Negligencia Algorítmica”

Actualmente, no existe un marco legal claro y uniforme para la responsabilidad algorítmica. Los tribunales están adaptando principios legales tradicionales como la responsabilidad por productos defectuosos y la negligencia profesional, pero el ajuste es imperfecto. Están surgiendo nuevos conceptos, como la “negligencia algorítmica”, que buscarían definir un estándar de cuidado específico para el desarrollo y la implementación de sistemas de IA. La legislación futura, como la Ley de Inteligencia Artificial de la Unión Europea, busca establecer normas más claras, exigiendo transparencia, supervisión humana y robustez en los sistemas de alto riesgo.

Un Territorio Inexplorado que Requiere Reglas Claras

La pregunta de quién es el culpable cuando una IA falla no tiene una respuesta única. La responsabilidad probablemente será compartida, distribuida en una compleja red que incluye a desarrolladores, operadores y, en algunos casos, a los usuarios profesionales. A medida que la IA se vuelve más autónoma y poderosa, la necesidad de establecer un marco legal claro y robusto es más urgente que nunca. Sin él, la promesa de la innovación tecnológica podría verse eclipsada por la incertidumbre y la falta de protección para los consumidores.

La intersección entre la ley y la tecnología está definiendo nuestro futuro. ¿Quieres estar al día?

Suscríbete a nuestro newsletter para recibir análisis exclusivos sobre inteligencia artificial, regulación y el impacto de la tecnología en nuestra sociedad.